共计 1970 个字符,预计需要花费 5 分钟才能阅读完成。

作者:橘花Kikka(双层芝士汉堡)

1.工艺分析

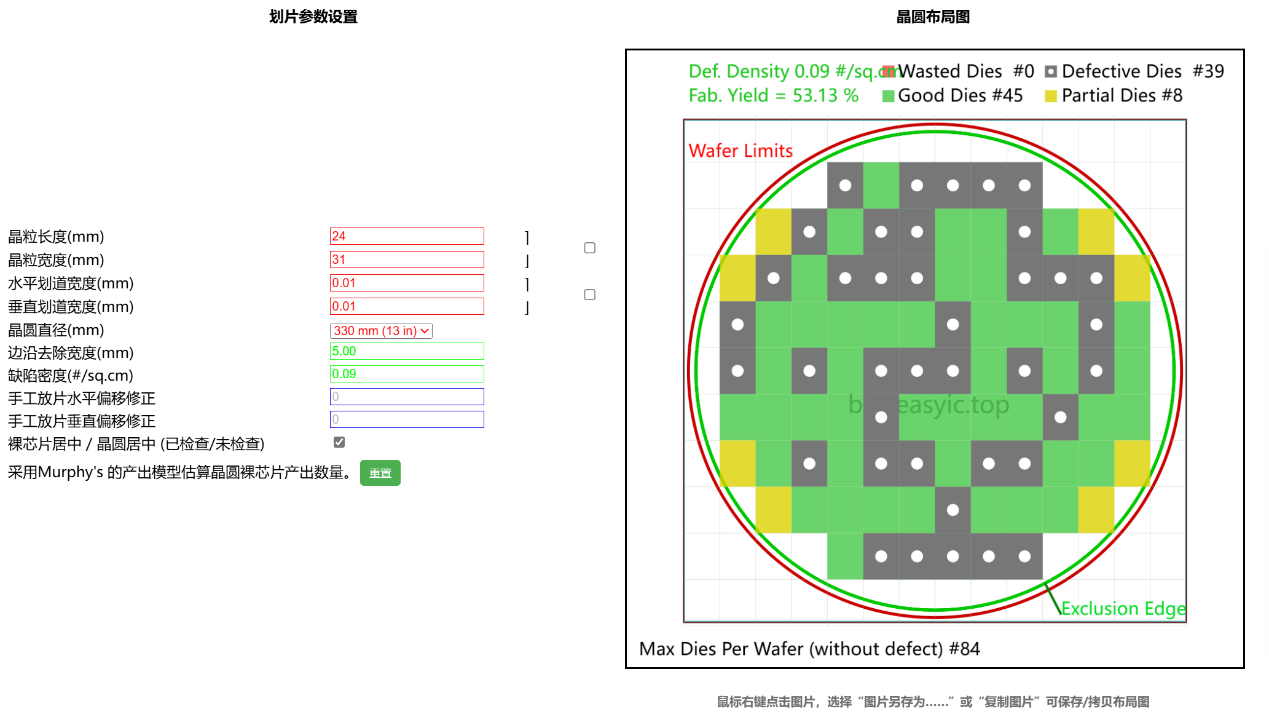

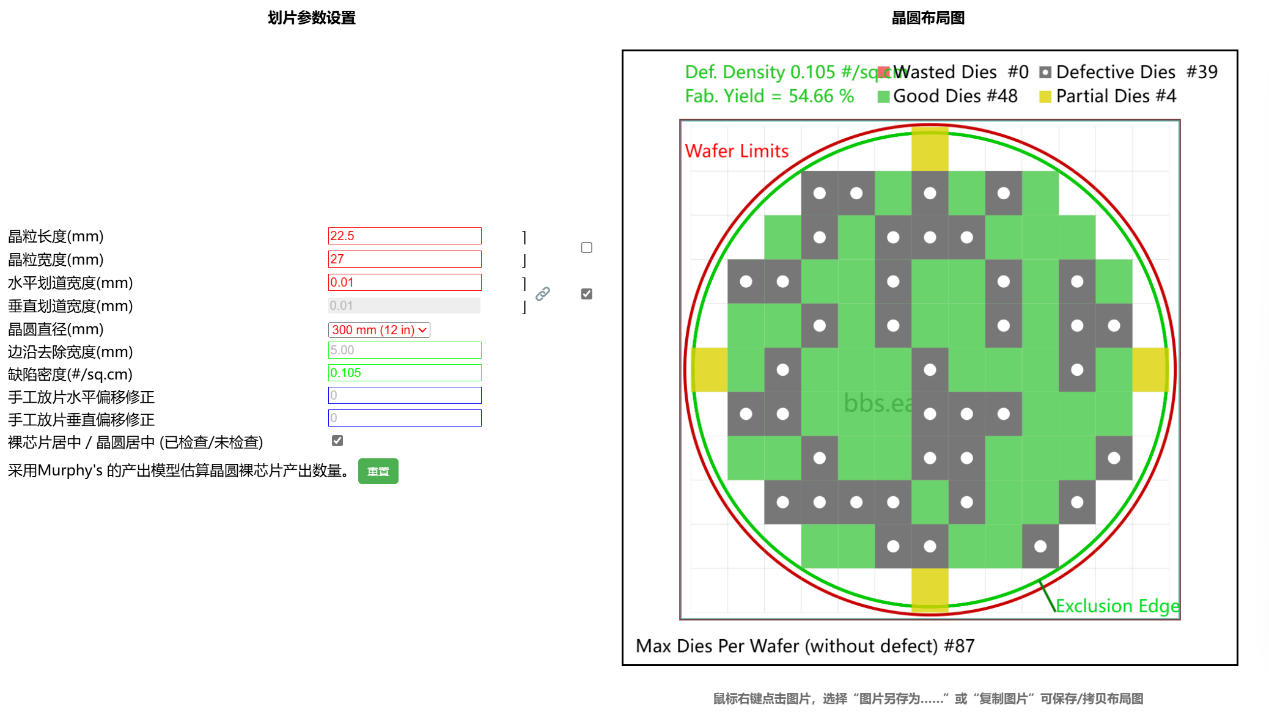

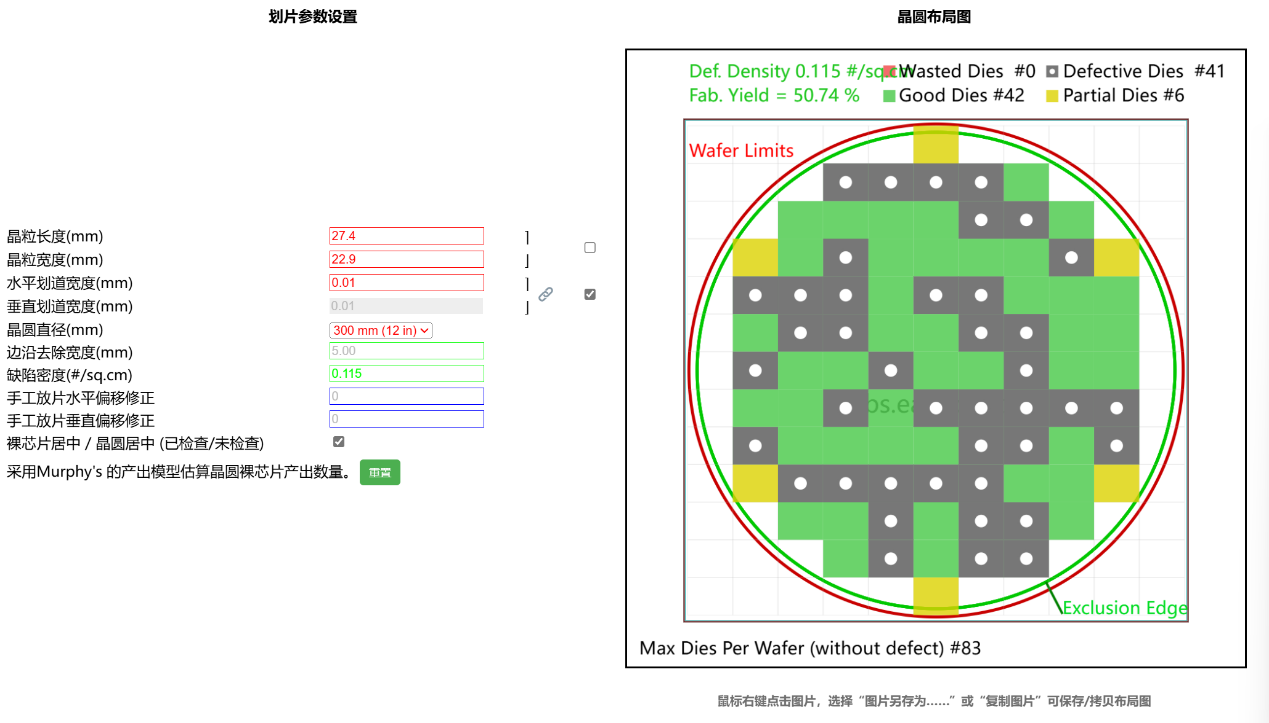

对新工艺TSMC 定制N4的单片die的成本计算,以及对比3090,4090的晶圆成本比重变化:假设缺陷概率为0.09,(纵横)划道宽度100微米,单片Wafer直径为13 inch(N4节点初期,12英寸为主流尺寸),单片Wafer价格为18K$,稼动率为80%。

本段内容多援引自外网Tom Hardware,具体数值及计算结果仅供参考。

5090单片die=18000÷45 Good die数量÷80%稼动率×1.1(PCM封装测试占用Wafer以及封装测试等的人工成本)≈550$≈4026¥

4090单片die=17500÷48÷80%×1.1=501$

3090单片die=8000÷42÷80%×1.1=262$(由于8nm实属于10nm的改良节点,此处Wafer报价是由TSMC 10nm报价5994$推导出的)

即3090/4090/5090晶圆成本占首发价的比值分别为17%/31%/27.5%,线性拟合总体看涨,不过鉴于Nv在40系以后的利润主要集中在中端显卡上,与此相对的,30系及30系以前的中端显卡性价比的代际差距却巨大无比,50系软件开发成本均摊部分较大等等缘故的对冲,我便姑且看作近三代迭代溢价率只是小有提升好了。

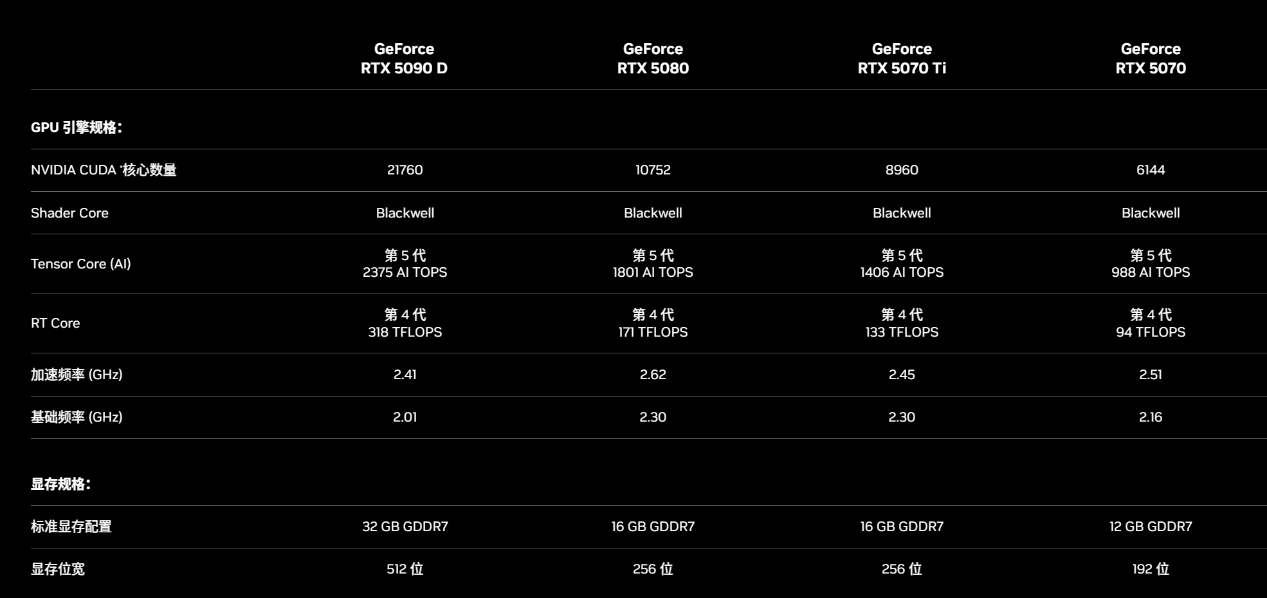

2.硬件规格,正式版驱动的性能小览

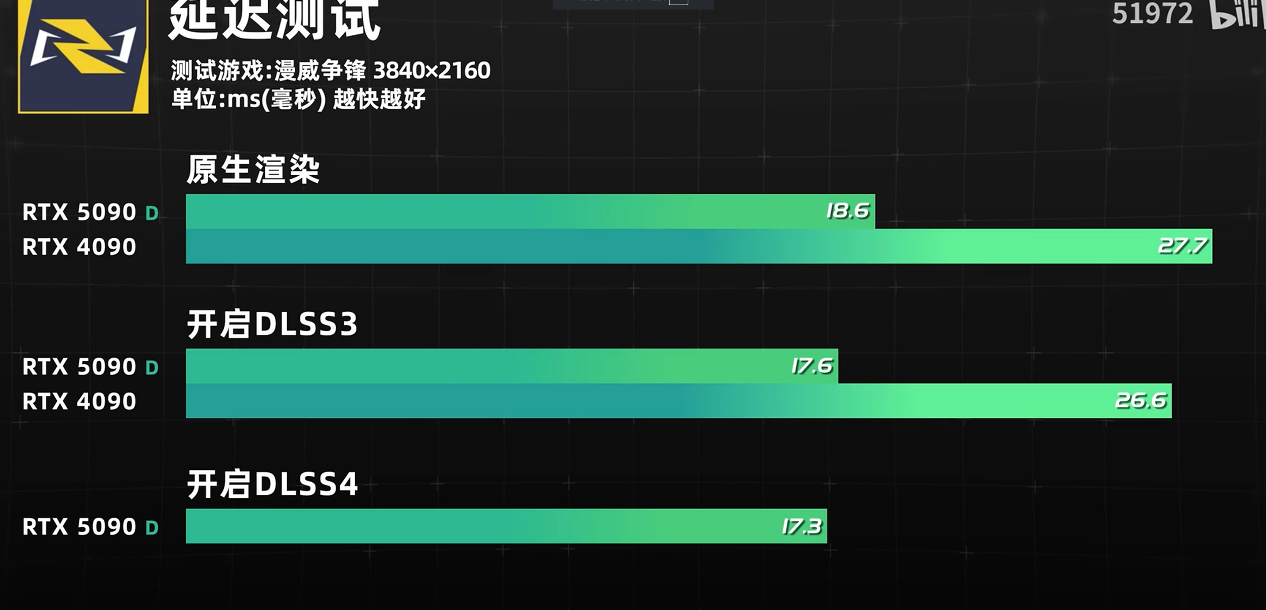

图片来源为B站@51972

3.DLSS 4 Trasformer/CNN(卷积神经网络)详解

今年可以说是Transformer的元年了,其核心原理在于输入有别于CNN的序列性数据,通过自注意力机制和多头注意力机制来生成高分辨率的图片。此外,由于Transformer的计算效率在24年得到有效解决(此处主要指的是选择性状态空间模型Mamba),结合它本身的跨模态适应性。除了图形学领域,其他领域的ai产品也有望看见Transformer的高速普及。

Transformer相较于CNN的主要优势在于其能够通过自注意力机制获取到距离更远,更全面的当前帧的上下文信息,继而更好的处理这些元素间的关系以及它们本身。与之相对的是CNN的上下文采集就只能限于局部了。

注意力机制虽然也可以被看作是CNN中的池化层,但相较来说更加动态,有利于在处理和output帧中保留更多的重要信息。

在Nvidia官方Demo中,Transformer相对于CNN的效果,在法线贴图和复杂形状元素等有一定改良,这些大小上远小于卷积核的元素在CNN方案上由于Scale和步长一致性以及感受野过大等原因而被稀释,故而效果不佳。(经典CNN中卷积核采集一般是步长一致的,鉴于Nv并没有给出详细的技术资料,此处待定)例如通风格栅,铁栅栏,动画水之类的,往常容易产生错误像素的复杂图形元素,在Transfomer方案上会有长足的进步。

4. AI光流帧生成,Neruo Material(神经纹理)

1.以往DLSS3的光流法补帧会将原本需要送显的当前帧和历史帧进行像素的矢量对比,求出生成帧,个人认为这种方法已经比手机上的独显芯片的像素取块再对比的补帧法质量高出一大截了,然而由于其本身仍然需要占用光栅化算力的缘故,这种补帧实在难称实用。

所以,我非常欣赏AI光流的一点是它相较于DLSS3来说降低了光栅化算力开销以及节约了原OFA的晶圆面积(并且使得没有OFA的老卡也有了支持插帧的可能),新范式允许插帧复用超分时的鉴权结果,计算权重分布来计算被插帧物体的关键特征,同以往所有DLSS技术一样运作在画面的后处理阶段(传统渲染完毕到送显前)。

尽管该技术宣称一次推理多帧生成,但是使用在非正式版驱动中,×4以及×2模式下的原始帧率仍然呈约10%的逐级递减,高倍帧生成的开销还有待观望。

2.神经纹理是一项作用于建模着色阶段的新技术,由开发者通过Nv官方提供的套件将纹理材质压缩至原大小的约四分之一,在着色阶段由AI模型进行推理还原并且还能顺带通过入射光的亮度角度等信息推理该纹理总体的高光分布以及每一个像素点应该着什么色,原传统Shader则在新的管线中起到传统参数-张量参数的转换作用而非求解brdf积分。

该技术不仅仅解放了纹理占用的大量显存,以及缓解了显存流量的压力,改善纹理的光线动态变化等,也和前文提到的技术一样有利于节约Shader占用的传统算力,有助于在光栅化以及光栅化+RT的混合工况下提高性能(纯RT工况就难说咯)。

总结来说,CES2025更像是一场图形学技术发布会,50系本身的光栅性能进步并不大,现有的性能进步几乎都是软件的进步,且溢价率小有提升。

软件革新也是革新,不看好AI管线的人和当初不看好计算摄影的人是同一个性质,只能说50系本身并没有太多的硬件性限制并且下放了足够多的新技术给老卡,不逼用户买新卡就是好文明!

本篇评测版权归图拉丁Club所有,如需转载请注明出

现在论坛没有登陆入口了吗